Tiltása robotok txt

Mit jelent letiltja a robots.txt?

Tiltása az egyik fő irányelvek, amelyek a robotok txt fájlt.

A robotok txt kerüléséhez mindig együtt használják az irányelv és a felhasználó-szert használunk, hogy korlátozza a hozzáférést a webhely oldalain.

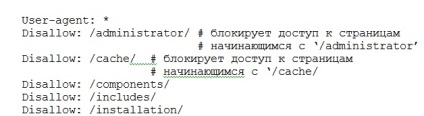

Tiltása a robotok txt lehet több. Tény, hogy hány ilyen irányelvek korlátozott, csak a méret a robots.txt fájlt (1. ábra).

1. ábra száma letiltja a robots.txt fájlban korlátozott, csak a méret

letiltja az irányelv vonatkozik minden robot külön-külön. robot neve van megadva az irányelv felhasználói ügynök.

Ha a felhasználói ügynök név helyett érdemes egy csillag (*), majd alkalmazni tiltsa le az összes robotot a látogató az oldalon.

Hogyan lehet regisztrálni disallow

Miután letiltja irányelvek rodots txt mindig kettőspont (:), majd a paramétereit, meg az utat a helyszínen

A hiányzó lehetőségek a disallow irányelveknek való teljes hozzáférést biztosít az összes oldalt az oldal, mint például:

User-agent: * # * paraméter azt jelzi, hogy az irányelv

# Tiltása vonatkozik minden robotot

Tiltása: # hozzáférés mindenki számára nyitott oldalak

Paraméter perjel (/), hogy ne engedélyezze a robotok txt blokkolja a hozzáférést az összes oldalt az oldal. Természetesen, ha egyedül használjuk ezeket, például:

Tiltása: / # Belépés csak minden oldalt az oldal

Számának csökkentése érdekében az irányelvek nem engedélyezi a robots.txt. akkor lehet alkalmazni, az úgynevezett reguláris kifejezéseket. A lényeg az, hogy az a paraméter, hogy ne engedélyezze a meghatározott home könyvtár, majd egy speciális karakter csillaggal (*). A * azt jelenti, bármilyen karaktersor, köztük üres. Például:

Tiltása: / administrator / * # blokkolja a hozzáférést a kezdődő oldalak

# '/ Adminisztrátor, majd minden karaktert

Disallow: / * / cache # blokkolja a hozzáférést tartalmazó oldalak útvonal

Alapértelmezésben a * karaktert tulajdonítják, hogy a végén minden szabályt a disallow irányelvet.

Azaz, még ha nem tesz a végén a * karakter, úgy gondoljuk, hogy ott van. Meg kell szem előtt tartanunk.

Ez a szabály lehet törölni alkalmazásával, hogy ne engedélyezze a robotok txt irányelv végén egy speciális karakter - dollár ($). Ez törli az alapértelmezett szabály - * végén az út. Például:

Disallow: / komponens # lezárja a hozzáférést az oldalak, kezdve

# 'Komponens', például, a 'komponens'; /, 'component.html' stb

Tiltása: / alkatrész $ # tiltja path „alkatrész”, de nem zár

# Hozzáférés az oldal „component.html” és mások.

Így, ami egy bizonyos reguláris kifejezések használatával speciális karakterek „*” és „$”, lehetséges, hogy lezárja a hozzáférést mind a teljes könyvtárak, valamint egy külön oldalt. Ez jelentősen csökkenti az idő, hogy hozzon létre egy robots.txt fájlt, és csökkenti a hangerőt. A tény az, hogy a robots.txt fájl korlátozza hangerőt.

A robotok txt kerüléséhez irányelv megbízhatóan megakadályozza a hozzáférést bizonyos oldalak a helyszín. Ezért létre egy fájlt, akkor ellenőrizni kell az eredmény a tetteiért.

Ehhez először ellenőrizze a fájl maga, majd követni az indexelés oldalak előtt és után az irányelv alkalmazásának disallowrobotstxt. By the way, a robots.txt fájlt a gyökérkönyvtárban a helyén.

Ui A fájl robots.txt letiltja dirrektiva univerzális minden típusú CMS - rendszerek. Függetlenül attól, hogy joomla, wordpress, vagy bármely más tartalomkezelő rendszer.